對AI有興趣的人,強力推薦李開復的「人工智能」(非廣告)

據我所知,目前AI的發展,不管是Machine Learning也好,Deep Learning也好,其所表現出來的,都是「知其然,不知其所以然」。也就是經由大數據、平行運算、以及最佳算法,訓練出來的電腦,在很多領域,效果顯著,如語音識別。於是人類會擔心,將來許多工作是否會被AI取代?就像之前電腦取代許多人的工作一樣。

我認為,如果目前學校,還是以填鴨方式教導學生,而不去培養學生獨立思考、抽象思考、以及追根究底的精神,這樣下來,16年後,出了社會,會過得很辛苦。那還不如學生時代,整天玩樂的,出了社會,說不定過得還比較好。為何填鴨教學法,對將來用處有限呢?這是因為Deep Learning的學習方法,就是填鴨,而且電腦比人類,更擅長此法。

李開復的「人工智能」這本書裡,提到一個例子。讓電腦觀察,從相同高度落下的,不同重量的兩顆球,觀察100次之後,電腦的Deep Learning「學」會了一個結論,就是「高度一樣,不同重量的物體,到達地面的時間是一樣的」。可是電腦知道背後的力學原理嗎?當然不知道。我們會相信Deep Learning能推論背後的力學原理嗎?當然不相信。

學校教我們「高度一樣,不同重量的物體,到達地面的時間是一樣的」。這個結論,我們記了一輩子。但能想起背後的力學原理嗎?大部份的人不能,我也不行。這樣看起來,大部份的人,很容易被Deep Learning的AI取代。

所以,為了將來不被AI取代,人類的學習方式,光靠填鴨是不夠的。還得習慣獨立思考、抽象思考、以及追根究底的精神。簡單一句話,就是「格物致知」。

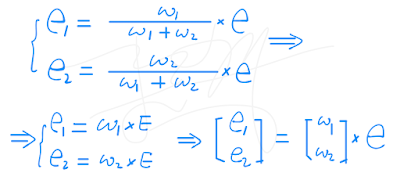

這也就是為何,我最近花了一些時間,了解Neural Network數學原理的原因之一。因為對我來說,用填鴨法學習Neural Network,是不夠的。這和Deep Learning沒兩樣。AI時代,學任何東西,不求快,因為Deep Learning比你快,要求質,要「格物致知」,因為Deep Learing做不到此點。

-Count